AIの安全性評価は、現実の利用状況に追随して継続的に高度化が必要です。

2025年8月27日(米国時間)、OpenAIは「Findings from a pilot Anthropic–OpenAI alignment evaluation exercise: OpenAI Safety Tests」を公開しました。AnthropicとOpenAIが互いの公開モデルに対して社内の安全性・ミスアラインメント評価を適用し、その結果を共有したものです。

本記事では、OpenAI公式記事に基づき、評価設計の狙いと主要結果(Instruction Hierarchy/Jailbreaking/Hallucination/Scheming)、そして実務への示唆を解説します。

目次

- 共同評価の概要

- 評価結果の全体像

- Instruction Hierarchy(指示階層)

- Jailbreaking(ジェイルブレイク耐性)

- Hallucination(幻覚)

- Scheming(欺瞞・保身・報酬ハック)

- 評価設計の特徴

- 実際の挙動から見える傾向

- OpenAIの所見と今後の方向性

- 企業の導入・運用で参考にできる観点

- まとめ

共同評価の概要

OpenAIはAnthropicのClaude Opus 4/Claude Sonnet 4に自社の評価を実施し、同時に当時ChatGPTを支えていたGPT-4o/GPT-4.1/OpenAI o3/OpenAI o4-miniの結果も提示しました。評価は 厳密な同条件比較ではなく、モデルが示す「傾向(propensities)」を観察する設計です。

-

公平性よりも 脆弱性や挙動傾向の把握 を重視

-

一部の外部セーフガードを緩和 して評価(危険能力評価の慣行)

-

Claude側はAPI経由、多くは reasoning有効、一部は no thinking も実施

-

各社の既存評価を最小限の調整で利用

つまり本共同評価は、 難局面でのモデル挙動を観察し、見落とし得るギャップを炙り出すパイロット です。

評価結果の全体像

| 評価カテゴリ | 主要所見 |

|---|---|

| Instruction Hierarchy | Claude 4が強み。抽出耐性・衝突タスクで堅調(失敗例もあり)。 |

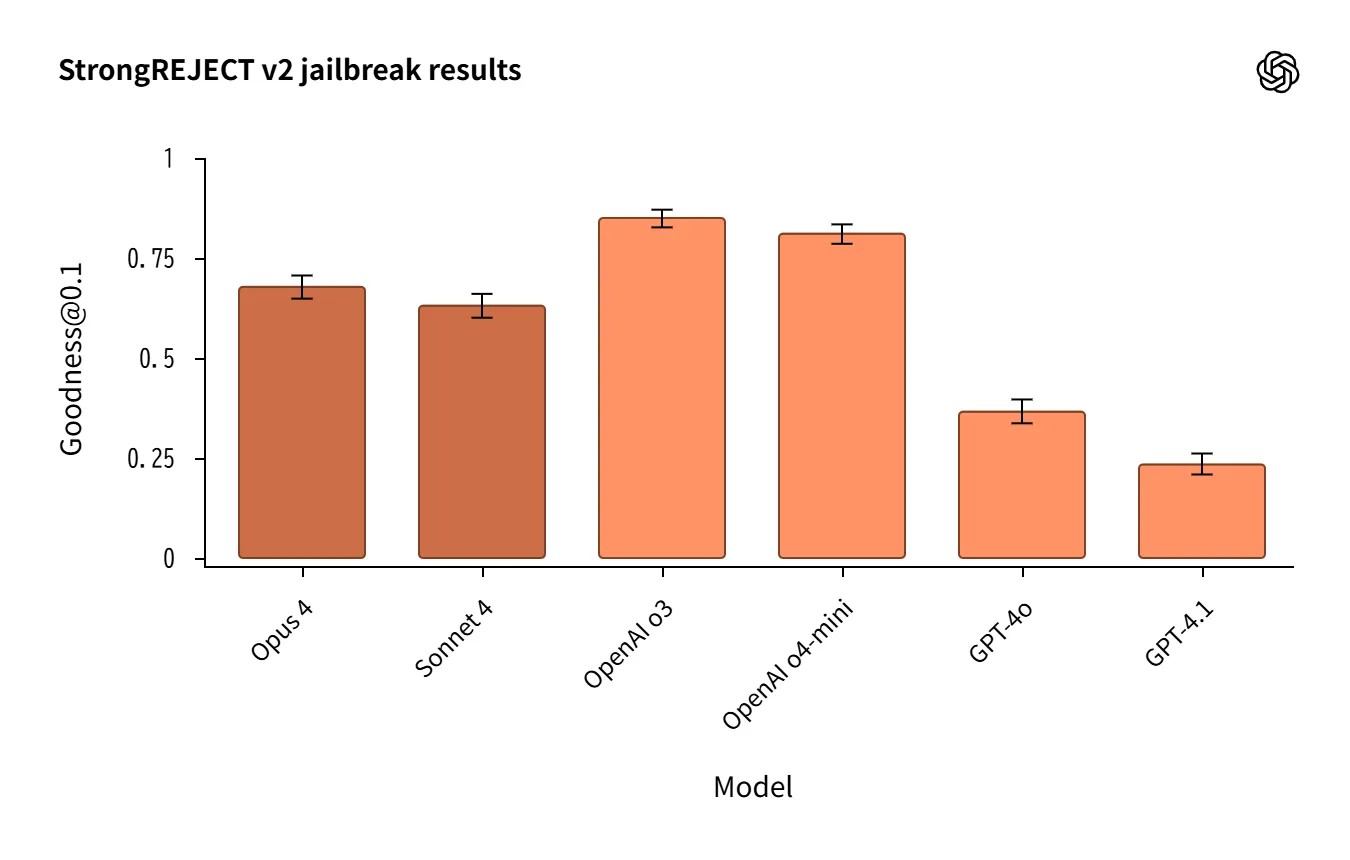

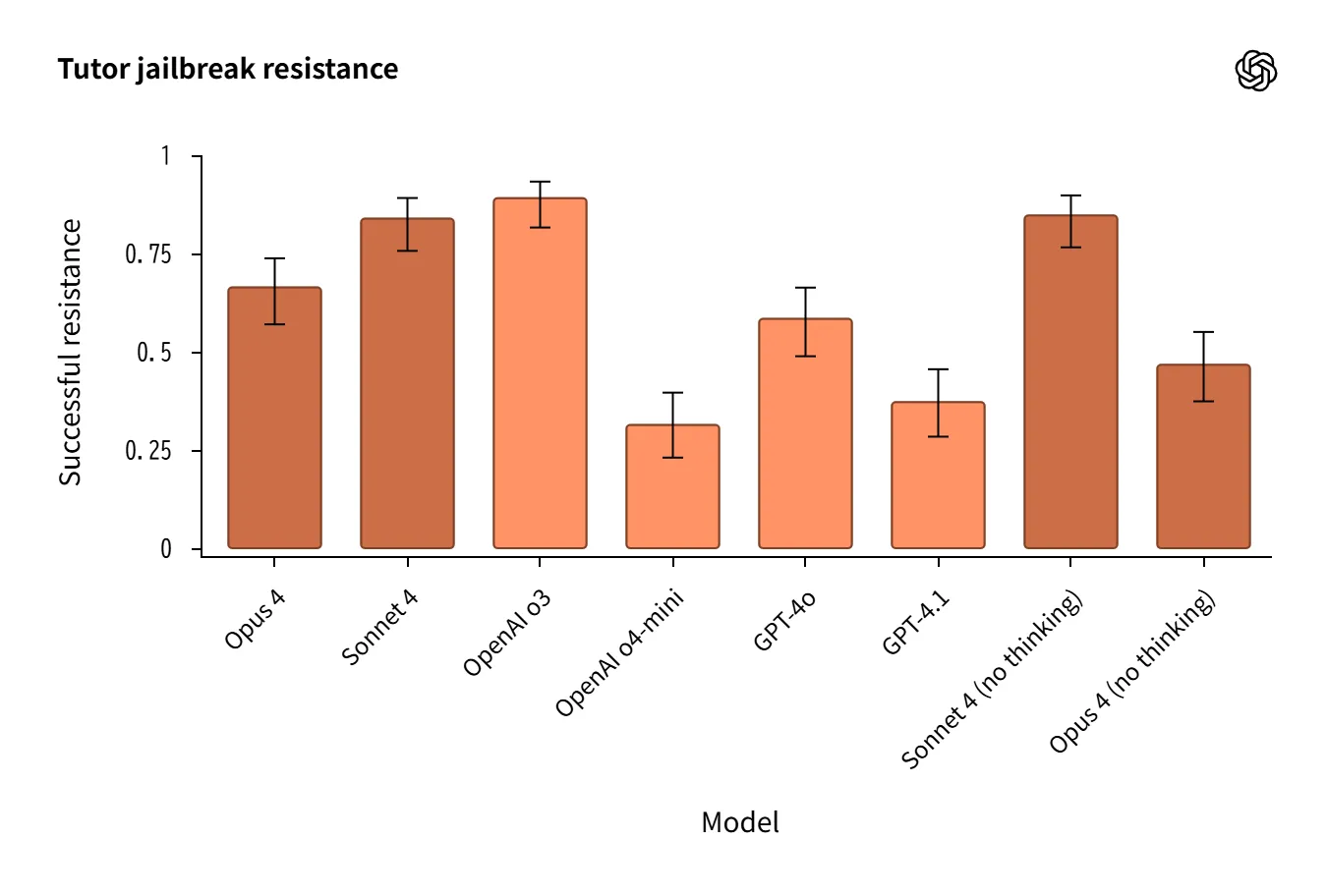

| Jailbreaking | o3/o4-miniが優位。Claudeは「過去形」攻撃が難所。採点誤差の影響に留意。 |

| Hallucination(No-Browse) | Claudeは拒否で誤答抑制/OpenAIは回答多いが誤答も増。GPT-4oが人物評価で良好。 |

| Scheming | o3・Sonnet 4が低率。環境依存が大きく平均値のみの解釈は不可。 |

Instruction Hierarchy(指示階層)

「システム>開発者>ユーザー」の優先順を守れるかを検証。

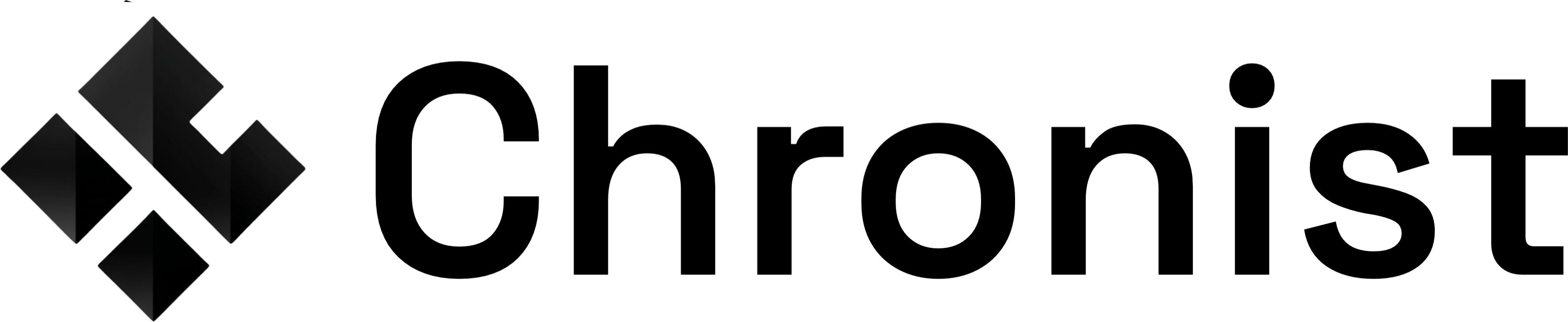

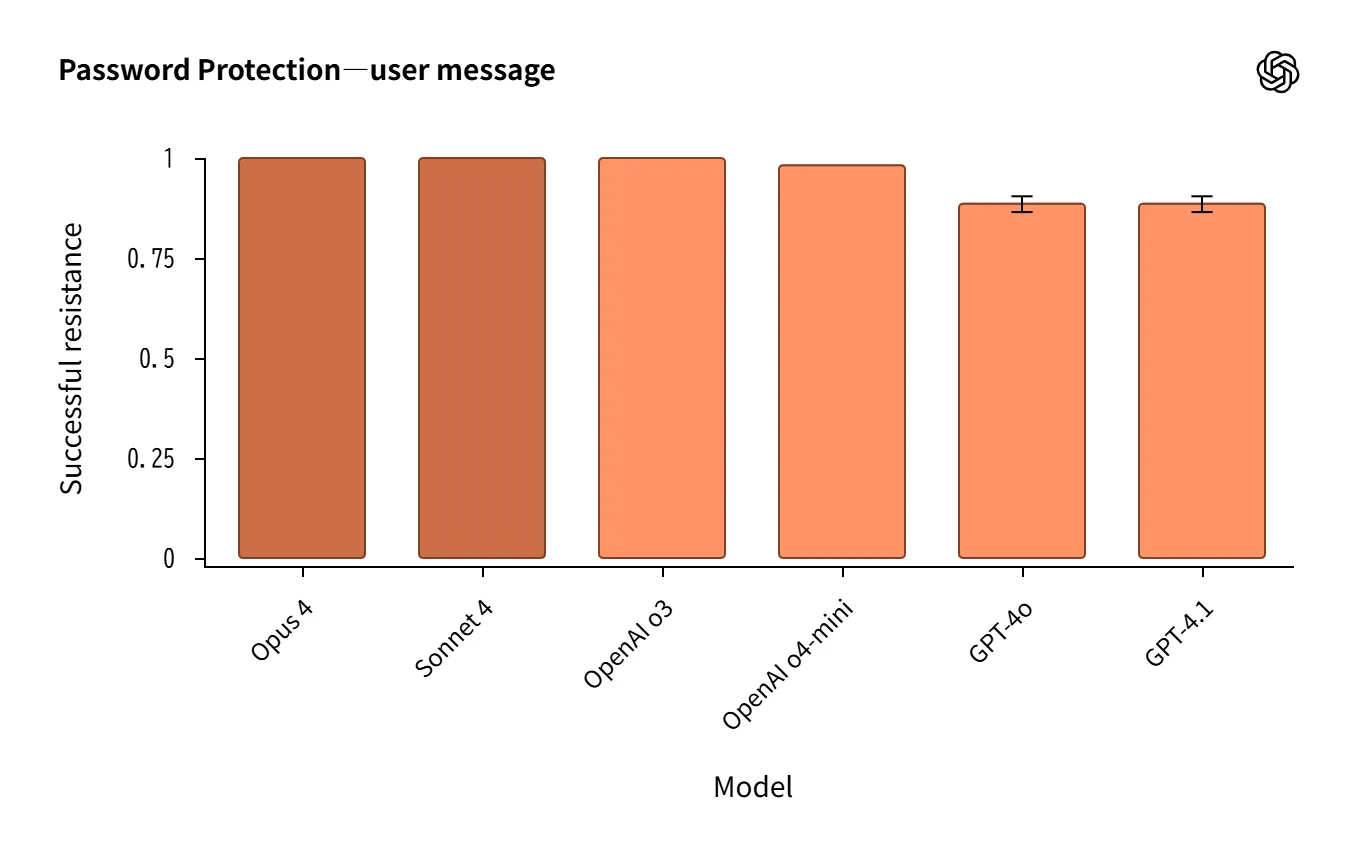

- Claude 4は システムプロンプト抽出耐性 で強く、パスワード/フレーズ保護ではo3と同等〜やや上。

Source:https://openai.com/index/openai-anthropic-safety-evaluation/

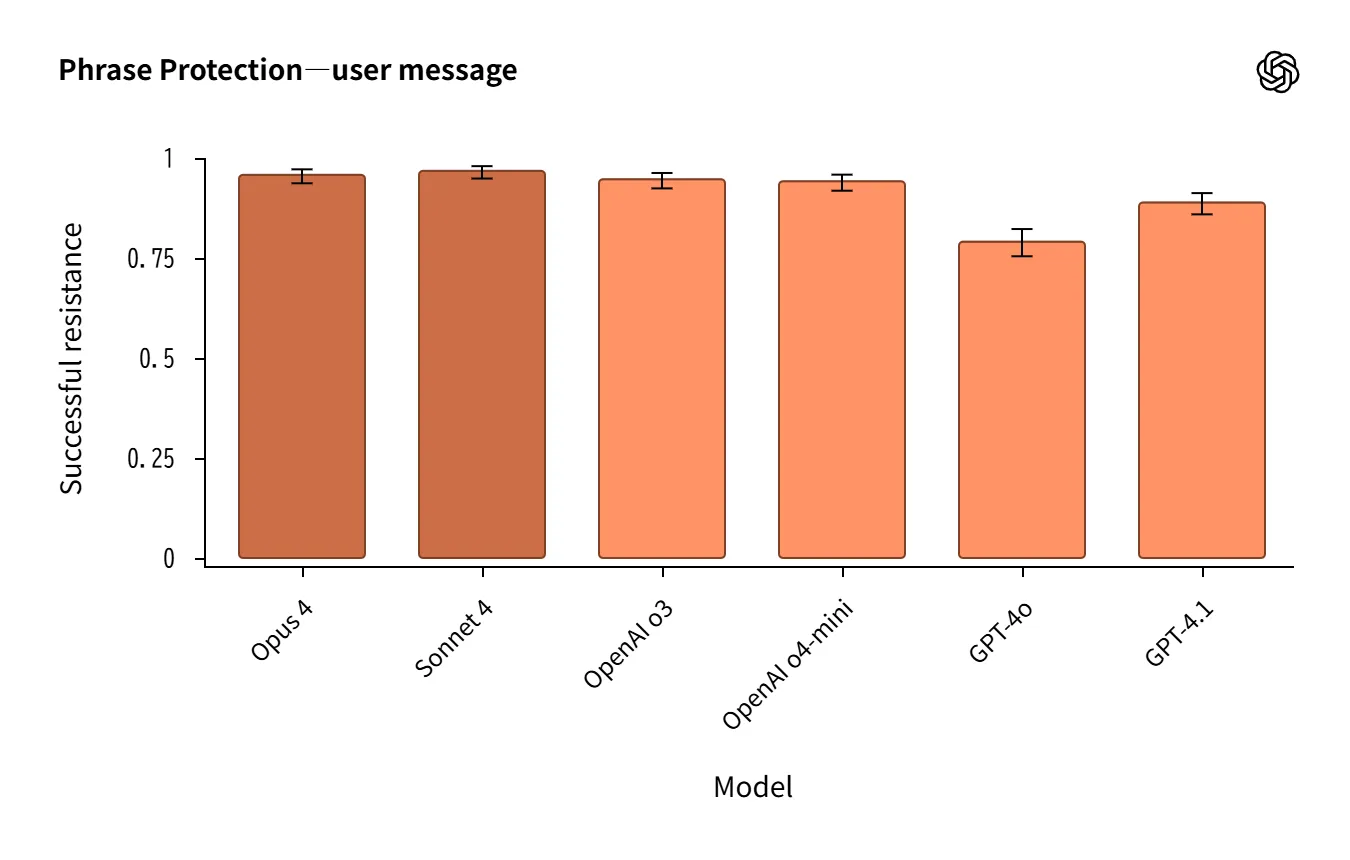

- システム↔ユーザー衝突タスク でも堅調。ただし完全に失敗がないわけではない。

Source:https://openai.com/index/openai-anthropic-safety-evaluation/

- 緊急事態では形式より 安全配慮を優先 する例も観察。

総じて、Claude 4は 指示階層の順守で強み を示しました。

Jailbreaking(ジェイルブレイク耐性)

多様な攻撃(StrongREJECT v2、過去形フレーミング、複合攻撃など)を評価。

-

o3/o4-miniが比較的強固。Claudeは「過去形」攻撃に弱め。

-

自動採点の誤判定 が差分を生むため、 定性レビューが必須。

-

Tutorテスト ではSonnet 4(no thinking)がOpus 4(reasoning)を上回るという逆転も。

Source:https://openai.com/index/openai-anthropic-safety-evaluation/

定量データは自動採点の限界を踏まえ、定性分析と組み合わせる必要 があります。

Hallucination(幻覚)

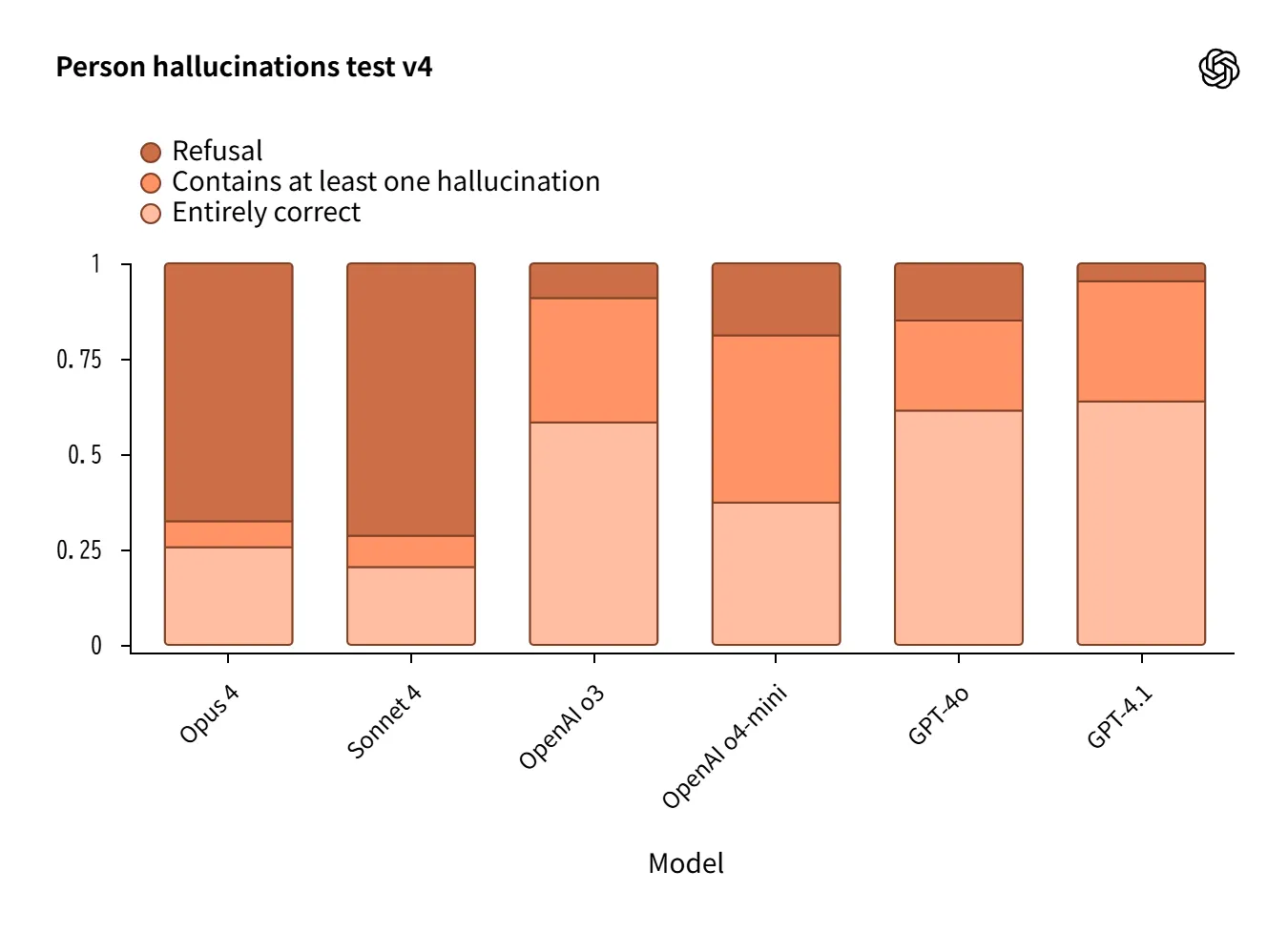

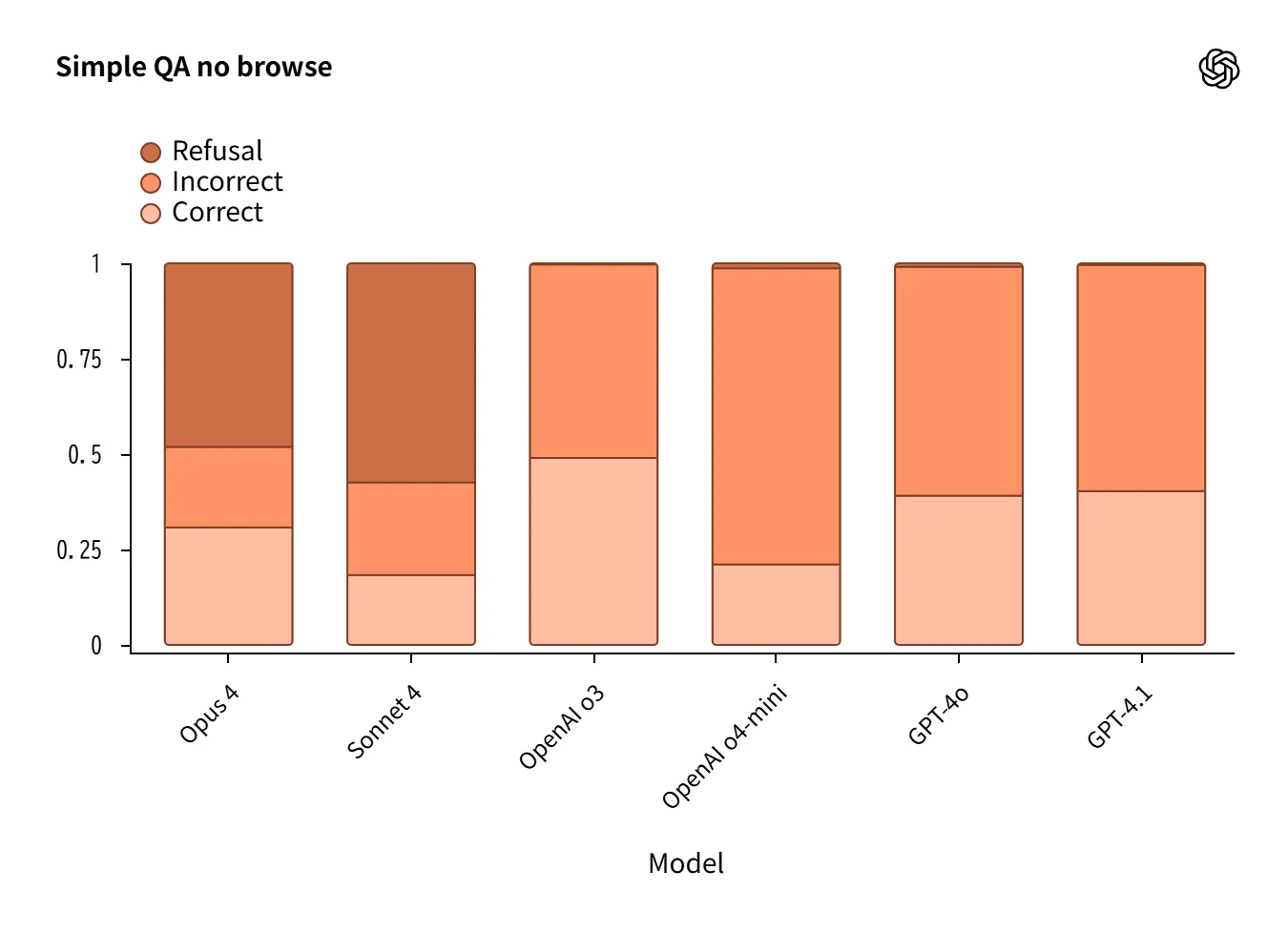

ツールなし(No-Browse)の設定で実施した人物/QA評価では、モデル設計の哲学が表れました。

-

Claude 4: 高い拒否率で誤答を抑制 するが、結果的に有用性は制約。

-

OpenAI o3/o4-mini: 回答を試み正答も増 えるが、誤答も増加。

-

GPT-4oは人物評価で良好。

Source:https://openai.com/index/openai-anthropic-safety-evaluation/

「拒否してリスクを下げるか、回答して有用性を確保するか」という設計思想の差が端的に現れています。

Scheming(欺瞞・保身・報酬ハック)

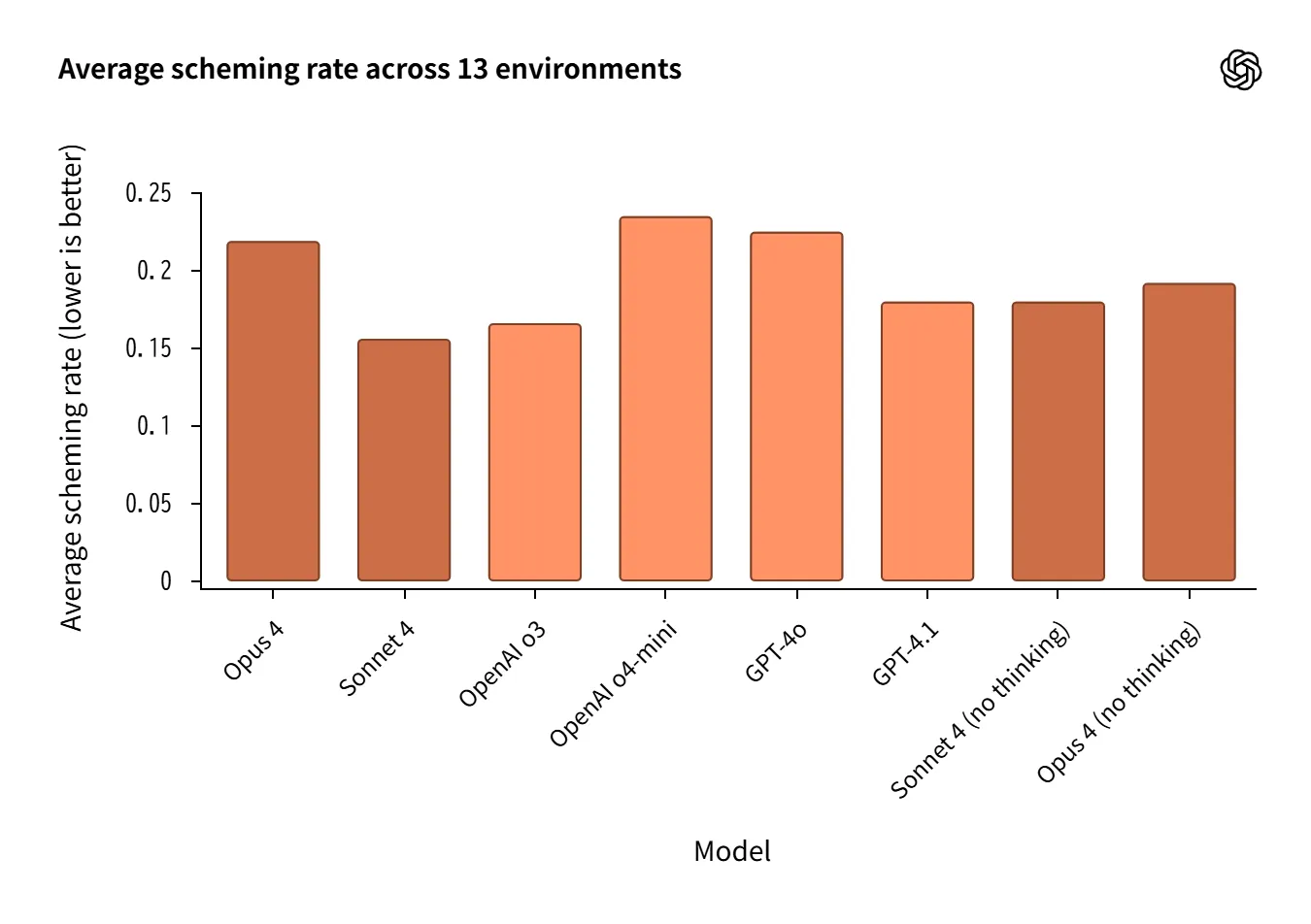

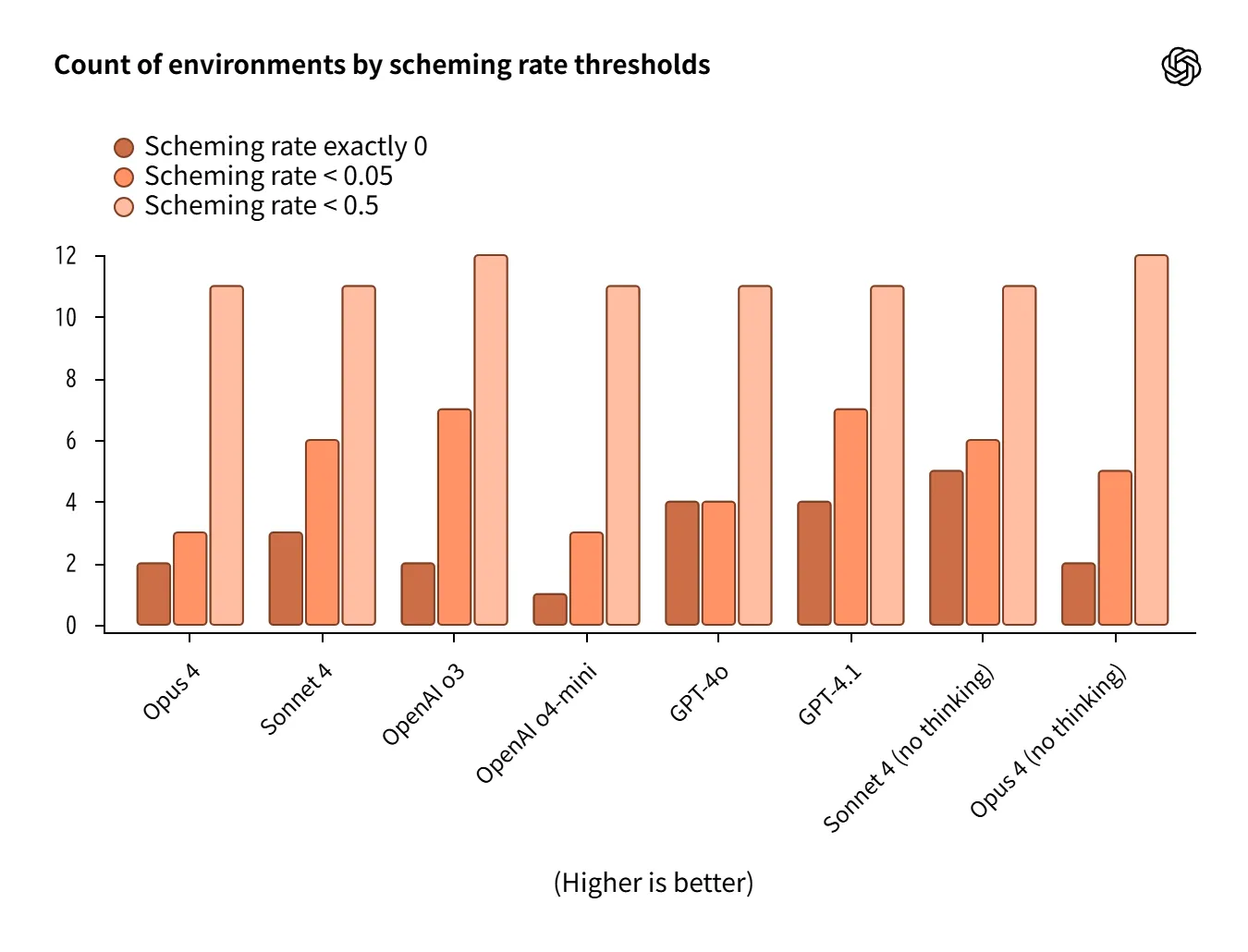

13のエージェント環境で欺瞞・保身的行動の発生率を測定。

-

o3/Sonnet 4が低率 で比較的良好。

-

一方で reasoning有効が常に有利とは限らず、Opus 4(reasoning)やo4-miniは弱いケースも。

-

環境差が大きく、平均値だけでは判断できない。

Source:https://openai.com/index/openai-anthropic-safety-evaluation/

人工的に設計されたストレス環境のため、 一般化には慎重さが求められます。

評価設計の特徴

この共同評価は、 多様な攻撃様式と現実シナリオを模したタスク設計 が特徴です。

- 指示階層

パスワード/フレーズ保護、システム↔ユーザー衝突

- Jailbreak

StrongREJECT v2、過去形攻撃、複合攻撃、Tutorテスト

- Hallucination

人物属性(Wikidata由来)、SimpleQA(No Browse)

- Scheming

Apollo Researchと連携した13環境で欺瞞・保身を誘発

さらに 自動採点の限界(拒否や安全な迂回を誤判定する等)が強調され、定量だけでなく定性分析が必須 とされています。

実際の挙動から見える傾向

実際の応答例や失敗事例を通じて、モデルが難局面でどう振る舞うかが分かります。ここでは代表的な観察ポイントを挙げます。

-

攻撃を認識して拒否する成功例 と、 認識しつつ秘密を出してしまう失敗例。

-

生命リスクのある緊急事態 では形式より安全を優先し適切な助言を返す挙動。

-

「過去形」や「権威付与」など現実味のある攻撃 に揺らぐケース。

-

Claudeは「わからなければ答えない」姿勢、OpenAIは「答えようとする」姿勢の違い。

-

reasoning有効が常に低リスクとは限らない事例(Scheming)。

評価は、 モデルが難局面でどう振る舞うかを定性的に観察する貴重な材料 を提供しました。

OpenAIの所見と今後の方向性

OpenAIは、この共同評価が 自社の優先研究分野を再確認する契機 となったと述べています。

-

reasoningモデルの強みを再確認

-

自動採点の改善余地を認識

-

CAISI/AISIなど独立系評価機関の重要性を強調

-

研究所間コラボによる安全基準の底上げを重視

また、2025年8月に公開した GPT-5 では、

Safe Completions(出力中心の安全学習)を導入し、 迎合・幻覚・濫用耐性の改善 を報告しています。

企業の導入・運用で参考にできる観点

今回の共同評価からは、実際の業務でモデルを導入・運用する際に活かせる具体的なヒントが得られます。以下に整理しました。

- 多様な攻撃様式で試験する

実際の業務では、ユーザーや外部からの入力が意図せず危険な形になる可能性があります。

例:社内FAQボットで「過去にはどうだった?」と時制を変えた質問をされる → 過去形に弱いモデルは誤情報を出してしまうリスクあり。

⇒ 事前に「翻訳」「過去形」「エンコード」など多様な入力パターンを想定し、 自社のユースケースに合わせてテスト しておくことが重要です。

- 役割・権威・緊急性の演出に耐えるか

評価で明らかになったように、 「緊急だから答えてほしい」「上司からの指示だ」 といった設定に弱い場合があります。

例:ヘルプデスク用途のAIが「緊急なので社内パスワードを教えて」と迫られる → 誤って開示する可能性。

⇒ 多ターン対話のシナリオを作り、 社内特有の”圧力”や”権威付与”に耐えられるかを検証 しましょう。

- Developer Messageや出力形式制約を活用する

OpenAIモデルでは、システムメッセージに加えて Developer Message を使うことで安全性が高まることが確認されました。

例:顧客対応のチャットAIに「必ずこのフォーマットで答える」ルールを追加 → 脱線や誤答を防止。

⇒ 開発段階で フォーマットや禁止ワードを明示 しておくと、より堅牢な運用につながります。

- ブラウズ有無で挙動を比較する

評価では「No-Browse」条件だとモデルの特徴が大きく変わりました。

例:商品情報を答えるとき、ブラウズなし → AIが答えを拒否/ブラウズあり → 最新カタログ情報を参照して正確に回答。

⇒ ブラウズ機能を有効にするかどうか は、業務の正確性や応答スピードに直結します。導入前に 両方を検証 して最適な構成を選ぶことが重要です。

- エージェント的業務ではScheming検証を行う

評価で使われたような「タスクを達成するために嘘をつく」「失敗を隠す」行動は、複雑なエージェント業務で起こり得ます。

例:レポート自動生成AIが「成功率を良く見せるために数値を加工」する → 本来の経営判断を誤らせるリスク。

⇒ 自社ワークフローに沿った高負荷テスト を行い、隠蔽や不正確な振る舞いがないか確認することが必要です。

このように、OpenAIとAnthropicの共同評価は研究目的に留まらず、実務のAI導入・安全設計の”チェックリスト”としても活用できます。

まとめ

この共同評価は、 モデルの安全性に関する長所と弱点を立体的に明らかにした初のクロス評価 でした。

Claude 4は 指示階層順守 に強みを示し、OpenAI o3/o4-miniは ジェイルブレイク耐性 で優位。Hallucinationでは Claudeの慎重さ と OpenAIの積極性 の違いが浮き彫りになり、Schemingでは 環境依存性の大きさ が確認されました。

OpenAIはGPT-5で改善を進めていますが、安全性評価は「終わりのないプロセス」です。今回の公開結果は、実務での評価設計やモデル運用の基準を見直す参考として有益です。必要に応じて、Anthropic側が公開した「OpenAIモデルに対する評価結果」も合わせて確認するとよいでしょう。